Pour encadrer l’utilisation de l’IA tout en encourageant l’innovation, l’Union européenne a adopté l’AI Act qui vise à mettre en place des règles spécifiques en fonction des risques potentiels que chaque application de l’IA pourrait représenter pour les citoyens européens. Le but de ce règlement est de garantir que l’IA est utilisée de manière éthique, sécurisée et transparente tout en soutenant l’innovation.

Qu’est-ce que l’IA selon le règlement ?

Le règlement s’applique aux système d’intelligence artificielle (« SIA ») qui sont définis comme « un système automatisé qui est conçu pour fonctionner à différents niveaux d’autonomie et peut faire preuve d’une capacité d’adaptation après son déploiement, et qui, pour des objectifs explicites ou implicites, déduit, à partir des entrées qu’il reçoit, la manière de générer des sorties telles que des prédictions, du contenu, des recommandations ou des décisions qui peuvent influencer les environnements physiques ou virtuels ».

Quels sont les acteurs concernés par l’AI Act ?

Le règlement détermine cinq types d’acteurs, à savoir :

- le fournisseur,

- l’importateur,

- le distributeur,

- le fabricant du produit,

- le déployeur, autrement dit l’entreprise procédant à la mise en œuvre du SIA.

Le règlement a un effet extraterritorial et s’applique également à des acteurs qui sont établis en dehors de l’Union européenne ; ainsi, l’AI Act concerne :

- les fournisseurs qui distribuent ou utilisent des SIA dans l'Union européenne, que ces fournisseurs soient établis dans l'Union ou dans un pays tiers ;

- aux déployeurs de systèmes d'IA situés dans l'Union européenne ;

- aux fournisseurs et déployeurs de SIA situés dans un autre pays si les résultats générés par le système sont destinés à être utilisés dans l'Union européenne ;

- aux importateurs et aux distributeurs de SIA.

Cependant, toute utilisation de l’IA n’est pas soumise au règlement. En effet, l’AI Act prévoit plusieurs dérogations et exceptions en fonction du secteur de l’application de l’IA, comme :

- les activités de recherche, de développement et de prototypage qui ont lieu avant la mise sur le marché d'un système d'IA,

- les systèmes d'IA conçus exclusivement à des fins militaires, de défense ou de sécurité nationale, quel que soit le type d'entité exerçant ces activités,

- certains systèmes d’IA open source et gratuits dont les paramètres sont rendus publics.

Quelles sont les catégories de risques et les obligations qui en découlent ?

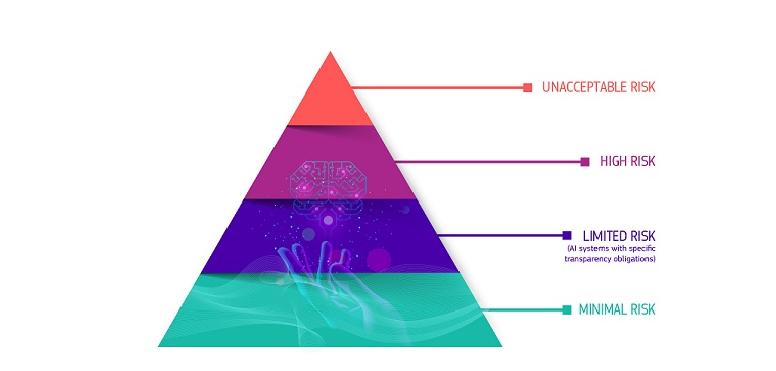

L’AI Act introduit une classification des SIA en quatre catégories selon leur niveau de risque, avec des exigences de conformité qui varient en fonction de ce niveau :

1) SIA à risque minimal ou nul : Le règlement autorise la libre utilisation de ces SIA.

Exemple : les filtres anti-spam.

La grande majorité des SIA actuellement utilisés dans l’UE entre dans cette catégorie. Ces systèmes ne sont pas soumis à des exigences strictes, ils peuvent donc être développés et utilisés à condition de respecter la législation en vigueur. Les fournisseurs de ces systèmes peuvent volontairement choisir d’adhérer à des codes de conduite.

2) SIA à risque limité : Ces SIA ont un impact limité mais présentent des risques associés au manque de transparence dans leur utilisation.

Exemples : utilisation d’un chatbot pour le service à la clientèle, les « deep fakes »

Le règlement introduit des obligations de transparence spécifiques pour veiller à ce que les personnes soient informées que ce à avec quoi elles interagissent est généré par l’IA.

3) SIA à risque élevé : Ces SIA sont utilisés dans des domaines sensibles comme la santé, la justice, la sécurité, ou les transports et peuvent avoir un impact significatif sur les droits et la sécurité des citoyens. C’est pourquoi ils sont soumis à un cadre réglementaire particulièrement strict.

Exemples : systèmes biométriques, systèmes utilisés dans le recrutement ou dans le système de notation des employés, pour des usages répressifs.

Ils doivent répondre à des exigences strictes en matière de gouvernance, de transparence, de contrôle humain et de gestion des risques.

Les fournisseurs et les déployeurs de ces SIA doivent notamment se conformer aux obligations suivantes :

| Obligations | Fournisseur | Déployeur |

| Évaluation de la conformité | Effectuer une évaluation complète avant la mise sur le marché | Vérifier la conformité avant le déploiement |

| Tests et certification | Réaliser des tests de sécurité et de performance | Vérifier que les tests ont bien été réalisés et validés |

| Documentation et traçabilité | Fournir toute la documentation technique et les rapports | Assurer que la documentation est disponible et vérifiable |

| Surveillance continue | Fournir des outils pour la surveillance continue | Mettre en place une surveillance continue post-déploiement |

| Transparence et explicabilité | Fournir des informations sur le fonctionnement de l'IA | Assurer la transparence et l'accès à l'explicabilité aux utilisateurs |

| Mise à jour et assistance | Fournir des mises à jour en cas de besoin | Appliquer les mises à jour et s'assurer de la conformité |

| Notification des incidents | Alerter le déployeur en cas de dysfonctionnement ou de risque | Notifier les autorités et les utilisateurs en cas d'incident |

• Risque inacceptable : L'IA est jugée dangereuse pour les droits et libertés des individus.

Exemples : la notation sociale, le recours à des techniques subliminales, l’utilisation par les services répressifs de l'identification biométrique à distance en temps réel dans des espaces accessibles au public, la police prédictive ciblant les individus, reconnaissance des émotions sur le lieu de travail et dans les établissements d'enseignement.

Ces technologies sont interdites.

(Source : site Internet de la Commission européenne)

Quid des modèles d’IA à usage général (ou « General purpose AI ») ?

L’AI Act encadre également les modèles dits à usage général, lesquels désignent des SIA conçus pour accomplir une grande variété de tâches, et non pour un domaine d'application spécifique.

Exemples :

- les modèles de langage (comme ChatGPT) capables de générer des textes, des images ;

- les assistants virtuels (Siri, Alexa) ;

- les systèmes d’apprentissage automatique qui peuvent être appliqués à des domaines aussi variés que la finance, le commerce, la logistique, ou la cybersécurité ;

- les plateformes de développement d'IA permettant aux entreprises de créer des applications personnalisées pour différents secteurs d'activité.

Pour cette catégorie, l’AI Act prévoit plusieurs niveaux d’obligation, à savoir :

- des obligations de transparence vis-à-vis des utilisateurs finaux,

- des obligations de gestion des risques (ces SIA doivent être conçues de manière à minimiser les risques, en particulier en ce qui concerne les biais, la sécurité des données et l'impact sur les droits des utilisateurs),

- des obligations d’évaluation de la performance et de la sécurité,

- des obligations de surveillance pour détecter d’éventuels problèmes ou dérives,

- et des obligations documentation minimales.

A partir de quand doit-on appliquer l’AI Act ?

L’AI Act est entré en vigueur le 2 août 2024 et son application est échelonnée :

- à compter du 2 février 2025 : interdiction des IA à risque inacceptable ;

- à compter du 2 août 2025 : entrée en vigueur des règles applicables aux modèles d’IA à usage général et nomination des autorités compétentes ;

- à compter du 2 août 2026 : application de toutes les dispositions et mise en place d’au moins un bac à sable réglementaire par les Etats membres de l’UE ;

- à compter du 2 août 2027 : entrée en vigueur des règles applicables aux IA à haut risque.

Quelles sont les sanctions ?

L'AI Act prévoit des sanctions allant de 1 % à 7 % du chiffre d’affaires annuel mondial de l’entreprise ou de 7,5 à 35 millions d’euros d’amende, selon la nature de la non-conformité.

Comment se préparer ?

Les entreprises qui développent ou utilisent de l’IA doivent anticiper dès à présent leur mise en conformité, en commençant par :

- identifier les systèmes d’IA utilisés et les évaluer afin de déterminer leur niveau de risque (haut risque, faible risque, etc.)

- désigner un responsable interne pour la conformité à l'IA,

- documenter tous les systèmes d'IA en maintenant un registre détaillé (description, finalité, risques associés, données utilisées),

- appliquer des mesures pour limiter les risques identifiés sur chaque système d’IA, en particulier pour les systèmes à haut risque.

Par Audrey PICHOT